我院在微观三维形貌重建方面取得重要进展

4月25日,我院录用在《中国科学: 信息科学》的“三维时频变换视角的智能微观三维形貌重建方法”论文,得到了《中国科学: 信息科学》官方微信的重点推送。

链接地址:https://mp.weixin.qq.com/s/B-bsGWl5gvS3ViOukkPDpw。

机器视觉与信号处理中心闫涛老师为论文第一作者,钱宇华教授为通讯作者,李飞江老师,闫泓任博士,王婕婷老师,梁吉业教授,郑珂银博士,吴鹏老师,陈路老师,乔志伟教授和张江峰硕士为合作作者。

微观三维形貌重建作为超精密三维显微设备的核心技术, 可对精密制造和工业测量领域中复杂零部件表面实现亚微米级精度的三维信息获取与检测, 为微细加工场景提供质量保证, 但微米级光学成像本身的局限性无法保证微观场景的高质量成像, 给高精度的三维形貌重建带来挑战. 现有方法在解决微观场景三维重建问题面临如下挑战:

(1) 图像序列采用一致的聚焦评价函数, 低对比度和稀疏纹理区域容易导致连续帧深度误差;

(2) 真实场景中无参考深度图像条件下, 高精度三维形貌重建结果的自适应生成困难;

(3) 传统方法获取的深度图像中, 难以利用图像序列蕴含的结构线索恢复完整深度信息.

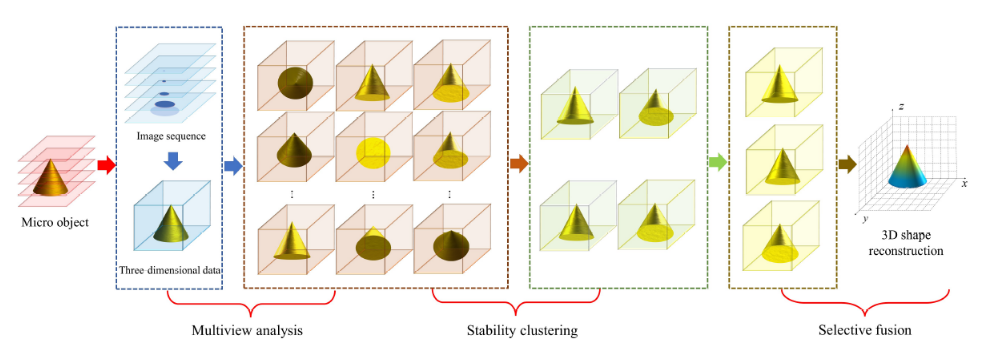

鉴于三维数据特有的多维度信息关联特性, 本文将微观物体的不同景深图像序列视为三维数据, 在重建过程中引入全部图像序列之间的关联关系, 从三维数据时频变换的视角构造了多视角分析、稳定性聚类、选择性融合三个逻辑耦合的微观三维形貌重建框架(图1)。

图1 三维时频变换视角的智能微观三维形貌重建框架。

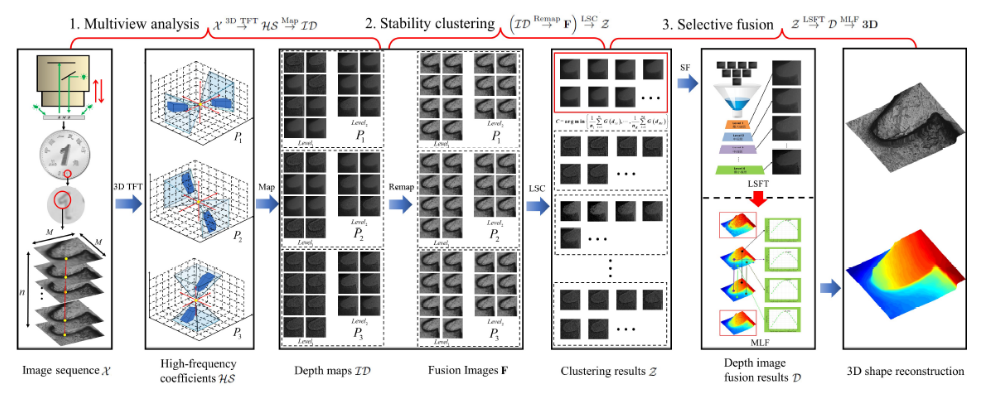

研究团队根据三维时频变换视角的智能微观三维形貌重建框架提出的3DTFT方法(图2所示)主要包括如下贡献:

(1) 在三维形貌重建过程中引入图像帧之间的关联关系, 从三维时频变换角度建立微观场景三维重建结果的多视角表达, 提升噪声类重建结果的分离性.

(2) 联合深度图像与融合图像的多模态图像特征, 提出具有良好抗噪性的局部稳定性深度图像聚类算法, 可实现真实场景中高质量深度图像的自适应选择.

(3) 针对多幅深度图像构造的选择性融合策略可保证离散噪声的有效滤除, 通过多层深度图像融合的方法实现微观物体高精度的三维形貌重建.

图2 3DTFT方法示意图

该研究工作得到山西大学大数据科学与产业研究院、计算智能与中文信息处理教育部重点实验室、山西省机器视觉与数据挖掘工程研究中心、国家重点研发计划、国家自然科学基金重点基金、科技创新2030-重大项目和山西省自然科学基金计划的支持。

研究成果原文阅读链接:

https://www.sciengine.com/SSI/article?doi=10.1360/SSI-2021-0386&scroll=

附:《中国科学:信息科学》是中国计算机学会推荐的A类中文期刊,中国通信学会推荐A类期刊。该期刊力求刊载信息科学领域最高学术水平的中文文章,及时报道计算机科学与技术、控制科学与控制工程、通信与信息系统、电子科学与技术等领域基础与应用研究方面的原创性成果。2021年共发表论文131篇。