机器学习实验室取得最新成果:从准确度中缓和随机一致性的学习

10月27日,机器学习期刊(Machine Learning, Springer)在线发表了我院机器学习实验室题为”Learning with Mitigating Random Consistency from the Accuracy Measure”的研究论文,是随机一致性视角下可学习理论系列核心成果之一。

可学习理论是统计机器学习的基本理论与算法约束。以PAC为代表的经典可学习理论中未充分考虑随机性带来的一致性程度,导致评测结果可能存在偏差。广泛存在的随机一致性可能动摇经典可学习理论的理论基础,对机器学习算法的泛化能力、公平性、可解释性等方面带来挑战。因而,如何建立随机一致性视角下的学习理论成为基本科学问题,这对人工智能诸多领域的理论研究与算法应用皆具有重要理论意义和推广价值。

该成果提出了一种期望意义下的随机一致性度量,给出了一种纯准确度度量指标PA,分析了PA在指导学习上对准确度的可替代性,证明了纯准确度损失(1-PA)的贝叶斯风险一致性,并基于PA重构了经典概率判别模型,实验表明重构后模型可取得更加优异的泛化性能与公平性。

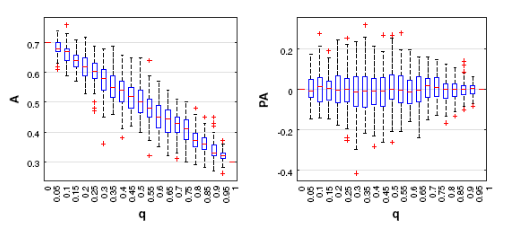

图: 纯准确度(右图)相较于准确度(左图)具有类别分布不敏感性

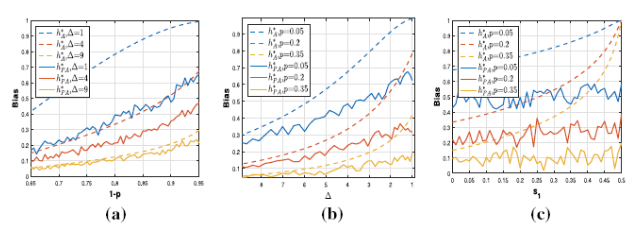

图: 纯准确度指导的分类器(实线)相较于准确度(虚线)的具有公平性

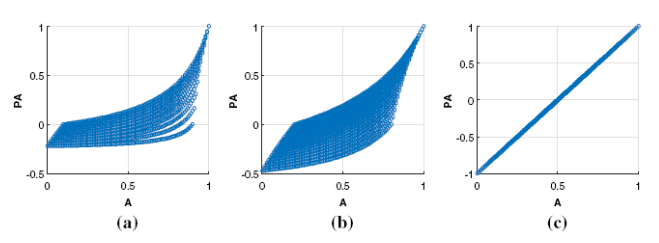

图: 纯准确度对于准确度具有学习替代性

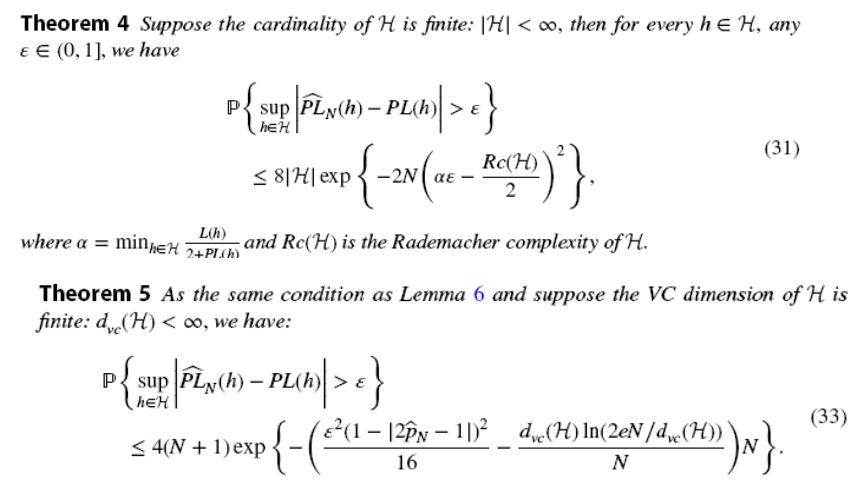

图: 定理4与定理5表明纯准确度具有贝叶斯风险一致性

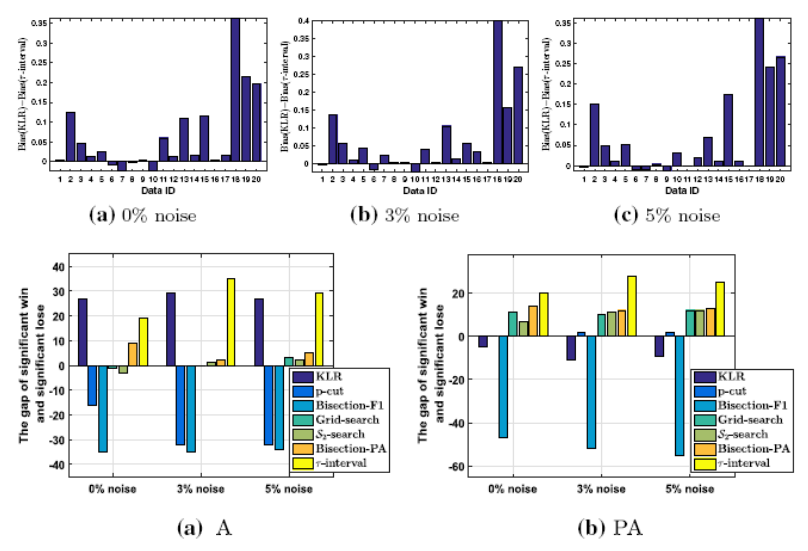

图:基于纯准确度的plug-in规则具有较强的公平性与泛化能力

2015级博士研究生王婕婷为该论文第一作者, 钱宇华教授为通讯作者, 李飞江博士为合作作者。这是我院首次在Machine Learning上发表研究成果, 该期刊是机器学习领域国际顶尖期刊。该项工作得到了国家重点研发项目、国家自然科学基金等项目的资助。