“演化数据智能”山西省科技创新领军团队五篇论文被2025IJCAI会议录用

近日,山西大学大数据科学与产业研究院五篇论文《Frequency-Aware Deep Depth from Focus》、《A Fast Neural Architecture Search Method for Multi-Modal Classification via Knowledge Sharing》、《View-Association-Guided Dynamic Multi-View Classification》、《A Multi-view Fusion Approach for Enhancing Speech Signals via Short-time Fractional Fourier Transform》、《An Association-based Fusion Method for Speech Enhancement》被2025年人工智能领域国际顶会IJCAI国际人工智能联合会议(International Joint Conference on Artificial Intelligence)接收。

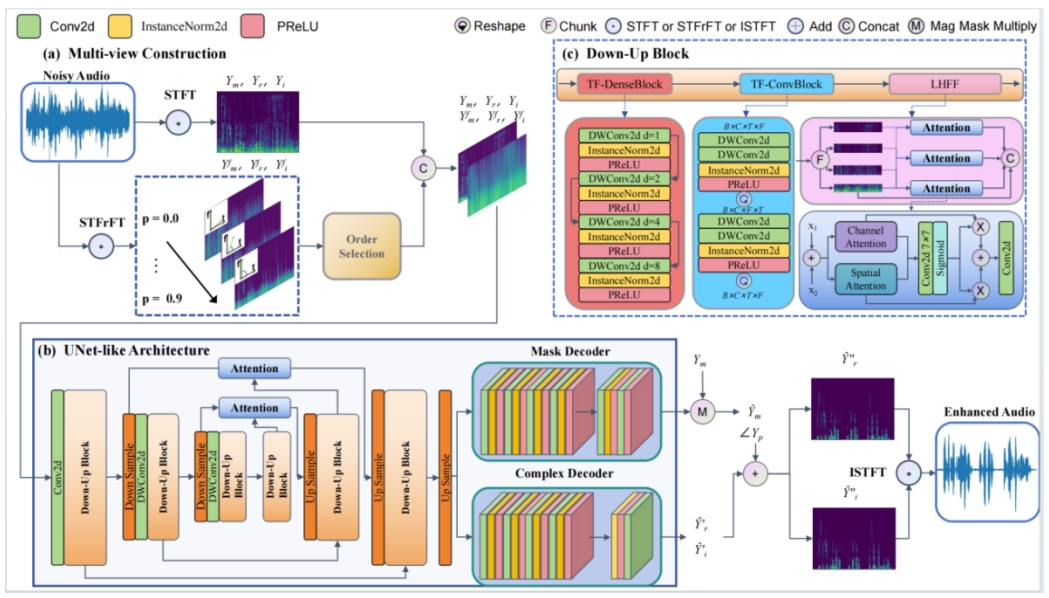

论文名称:《A Multi-view Fusion Approach for Enhancing Speech Signals via Short-time Fractional Fourier Transform》

论文作者:金子琨,钱宇华(通讯作者),梁新彦,耿海军

论文介绍:基于深度学习的语音增强(Speech Enhancement, SE)方法通常在时间域或频率域中重建语音信号,然而,这些传统域的信息表达能力有限,难以准确捕捉非平稳信号的动态特性。为此,本文提出了一种多视图融合语音增强方法(Multi-view Fusion Speech Enhancement, MFSE),以增强模型的表征能力。具体而言,MFSE 利用短时分数阶傅里叶变换(Short-Time Fractional Fourier Transform, STFrFT),将语音信号的表示空间从传统的时间-频率域扩展至两者之间的动态域空间。在此基础上,方法构建了由主视图短时傅里叶变换(STFT)谱和辅助视图STFrFT谱组成的多视图输入结构,并通过平均谱质心自适应地从连续的分数域中选取最优的STFrFT谱图。该框架通过多个精心设计的卷积模块提取潜在特征,同时利用多粒度注意力机制挖掘语音不同频率之间的相关性。实验结果表明,与现有基于时间域和频率域的单通道语音增强方法相比,所提出的方法在多个评估指标上均取得了显著提升。此外,泛化性能评估也显示,所提出的多视图方法在不同信噪比(SNR)条件下均优于单一视图方法。

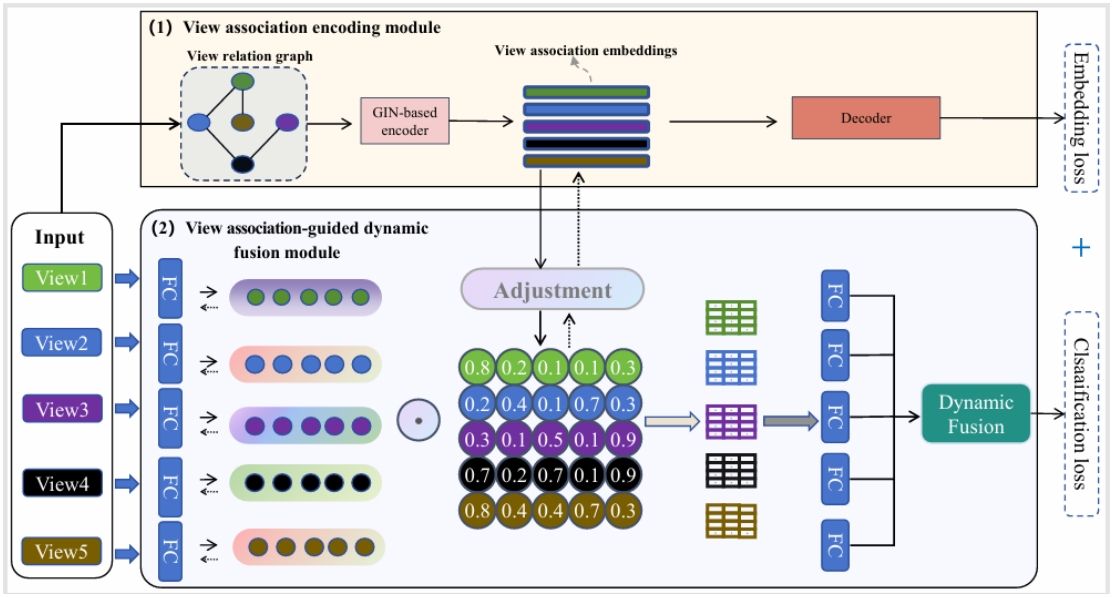

论文名称:《View-Association-Guided Dynamic Multi-View Classification》

论文作者:梁新彦,吕立,郭倩(通讯作者),江兵兵,李飞江,杜亮,陈路

论文介绍: 有效整合来自多个视图的信息对于多视图分类模型的性能提升至关重要。大多数现有方法未充分显示利用视图间复杂关联信息,往往将各视图独立处理或采用静态的融合策略。为此,本文提出了一种基于视图关联引导的动态多视图分类方法,通过引入一种视图关联引导机制,用于捕捉视图间的依赖性和交互关系,从而实现更灵活和自适应的特征融合。在多个基准数据集上的大量实验表明,所提方法统计上优于所对比的多视图分类方法,为处理复杂多视图数据任务提供了一种更稳健、高效的解决方案。

论文名称:《Frequency-Aware Deep Depth from Focus》

论文作者:闫涛,王莹莹,张江峰,钱宇华(通讯作者),贾洁茹,陈路,李飞江

论文介绍:在大光圈成像中,浅景深现象需要在不同焦距下捕捉多张图像,以便使用焦点深度(DFF)技术推断深度信息。然而,大多数先前的工作从时间域角度设计卷积神经网络,通常导致深度估计中的细节点模糊。在本工作中,我们提出了一种频率感知深度DFF网络(FAD),该网络结合了多尺度空间域局部特征与频率域全局结构特征。实验结果表明,我们的模型在多种不同分布的数据集上实现了最先进的深度预测。此外,它还可以作为预训练模型快速适应实际应用。

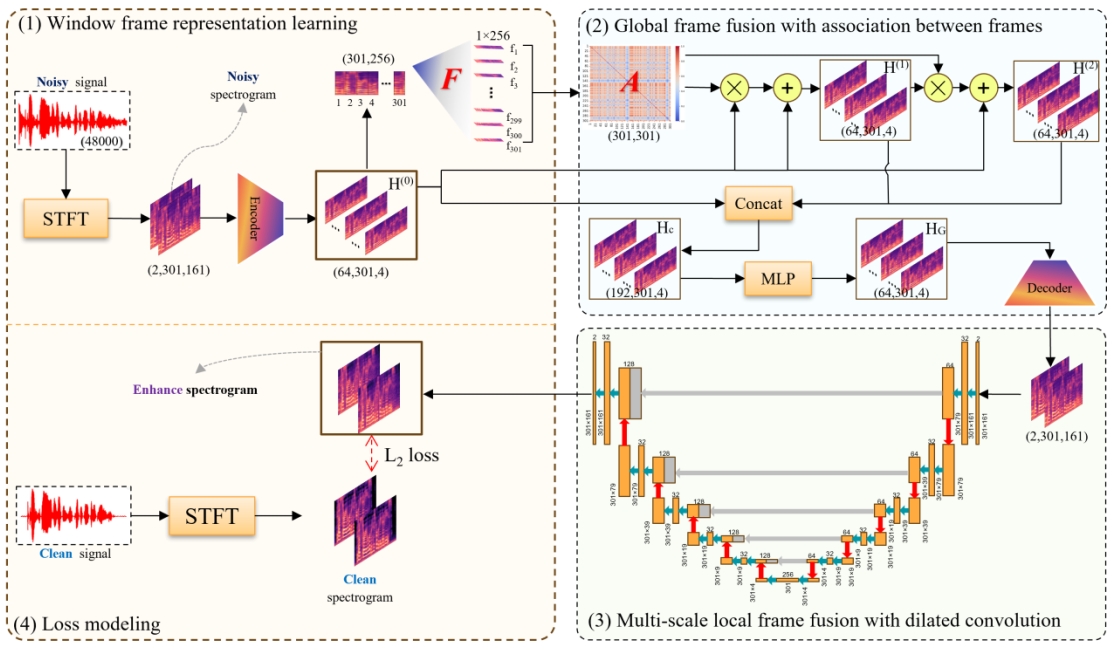

论文名称:《 An Association-based Fusion Method for Speech Enhancement》

论文作者:汪世杰,郭倩,陈路,杜亮,金子琨,原之安,梁新彦(通讯)

论文介绍:基于深度学习的语音增强(SE)方法主要依赖于两种架构框架:生成对抗网络和扩散模型。在语音增强领域,捕捉信号帧之间的局部和全局关系对于现有方法的成功至关重要。这些框架通常采用UNet架构作为基础骨干网络,在UNet中集成长短期记忆(LSTM)网络或注意力机制,以有效建模局部和全局信号关系。然而,耦合关系建模的方式可能没有充分发挥这些关系的潜力。本文提出了一种创新的基于关联的融合语音增强方法(AFSE),这是一种解耦式方法。AFSE首先构建一个图,封装每个时间窗口之间的关联,然后通过类似于图神经网络的方式融合这些时间窗口的特征,从而建模帧之间的全局关系。此外,AFSE利用具有膨胀卷积的UNet来建模局部关系,使网络能够保持高分辨率表示,同时从更广泛的感受野中受益。实验结果表明,AFSE方法在语音增强任务中显著提高了性能,验证了我们方法的有效性和优越性。

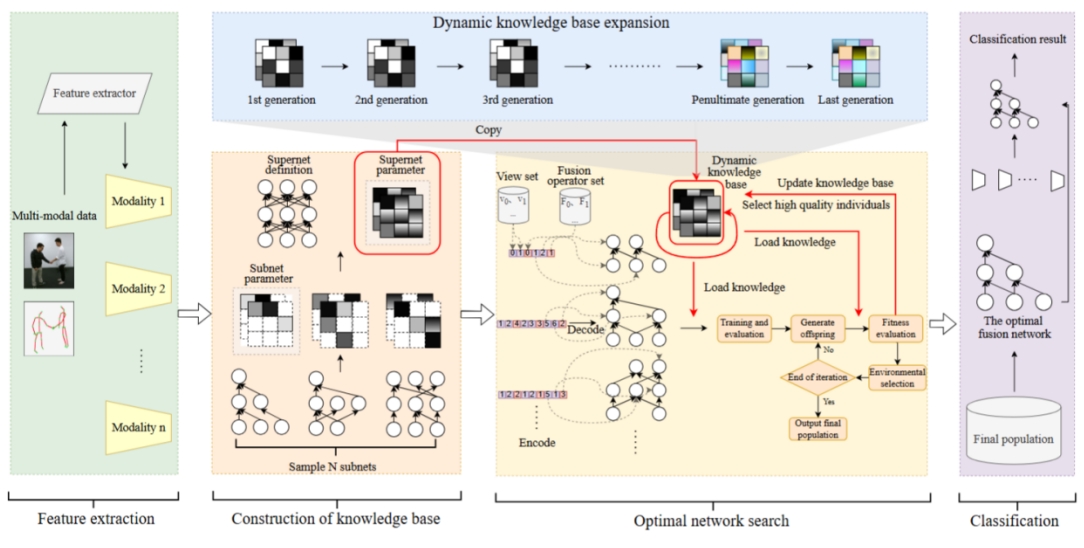

论文名称:《A Fast Neural Architecture Search Method for Multi-Modal Classification via Knowledge Sharing》

论文作者:崔志华,孙时武,郭倩(通讯作者),梁新彦,钱宇华,张志霞

论文介绍:基于神经架构搜索的多模态分类(NAS-MMC)旨在自动寻找最优的网络结构,以提升多模态分类的性能。然而,目前大多数NAS-MMC方法在训练过程中都非常耗时。在本文中,我们提出了一种基于知识共享的快速神经架构搜索方法(KS-NAS)用于多模态分类。该方法通过引入一个动态更新的知识库来优化搜索过程从而降低计算资源的消耗。具体来说,在深度演化搜索过程中,初代种群中的个体从一个知识库中获取初始参数,然后进行训练和优化直至达到收敛状态,避免了从头训练。知识库通过聚合种群中训练好的高质量个体参数进行动态更新,质量逐步提升。知识库便能随着种群的逐步进化而不断优化,从而确保后续个体能够获取到质量更高的初始化参数,显著加快了种群的训练速度。实验结果表明,在多个流行的多模态任务上,KS-NAS方法在分类性能、训练效率方面达到最先进的结果。

此外,团队成员梁新彦副教授和悉尼科技大学杨杰、杭州师范大学江兵兵副教授合作发表了《Multi-view Clustering via Multi-granularity Ensemble》。

IJCAI(International Joint Conference on Artificial Intelligence)是人工智能领域的顶级国际会议之一,由国际人工智能学会(IJCAI)主办。该会议每年举办一次,旨在促进人工智能领域的学术交流与合作。会议提供了一个国际性的平台,让学术界和工业界的研究人员、工程师、学生等共同探讨人工智能领域的最新进展、技术创新和应用实践。2025 IJCAI会议论文接收率为19.3%。